Hướng dẫn tạo và chỉnh sửa file robots.txt thủ công

Mục lục

File robots.txt đóng vai trò quan trọng trong việc hướng dẫn các công cụ tìm kiếm (Google, Bing…) cách thu thập dữ liệu trên website của bạn. Bằng cách tạo và chỉnh sửa robots.txt, bạn có thể kiểm soát những nội dung nào được lập chỉ mục và nội dung nào cần chặn, giúp tối ưu SEO và bảo vệ các dữ liệu quan trọng.

Trong hướng dẫn này, Zhost sẽ giúp bạn tạo và chỉnh sửa file robots.txt một cách thủ công, đảm bảo website hoạt động hiệu quả và tuân theo các tiêu chuẩn SEO tốt nhất.

Cấu trúc cơ bản của robots.txt

File robots.txt có cấu trúc đơn giản bao gồm các dòng lệnh quy định như sau:

User-agent: Chỉ định rằng bot nào sẽ tuân thủ theo quy tắc này.Disallow: Chỉ định rằng những đường dẫn không được phép truy cập.Allow: Chỉ định rằng những đường dẫn được phép truy cập.Sitemap: Khi báo URL của sơ đồ website (sitemap) để giúp bot tìm thấy nội dung dễ dàng hơn.

Dưới đây là ví dụ của một file robots.txt cơ bản:

User-agent: *

Disallow: /private/

Allow: /public/

Sitemap: https://example.com/sitemap.xml

Hướng dẫn thực hiện

Bước 1: Truy cập vào quản trị hosting.

Sử dụng tài khoản quản trị hosting để đăng nhập vào hosting chứa website của bạn.

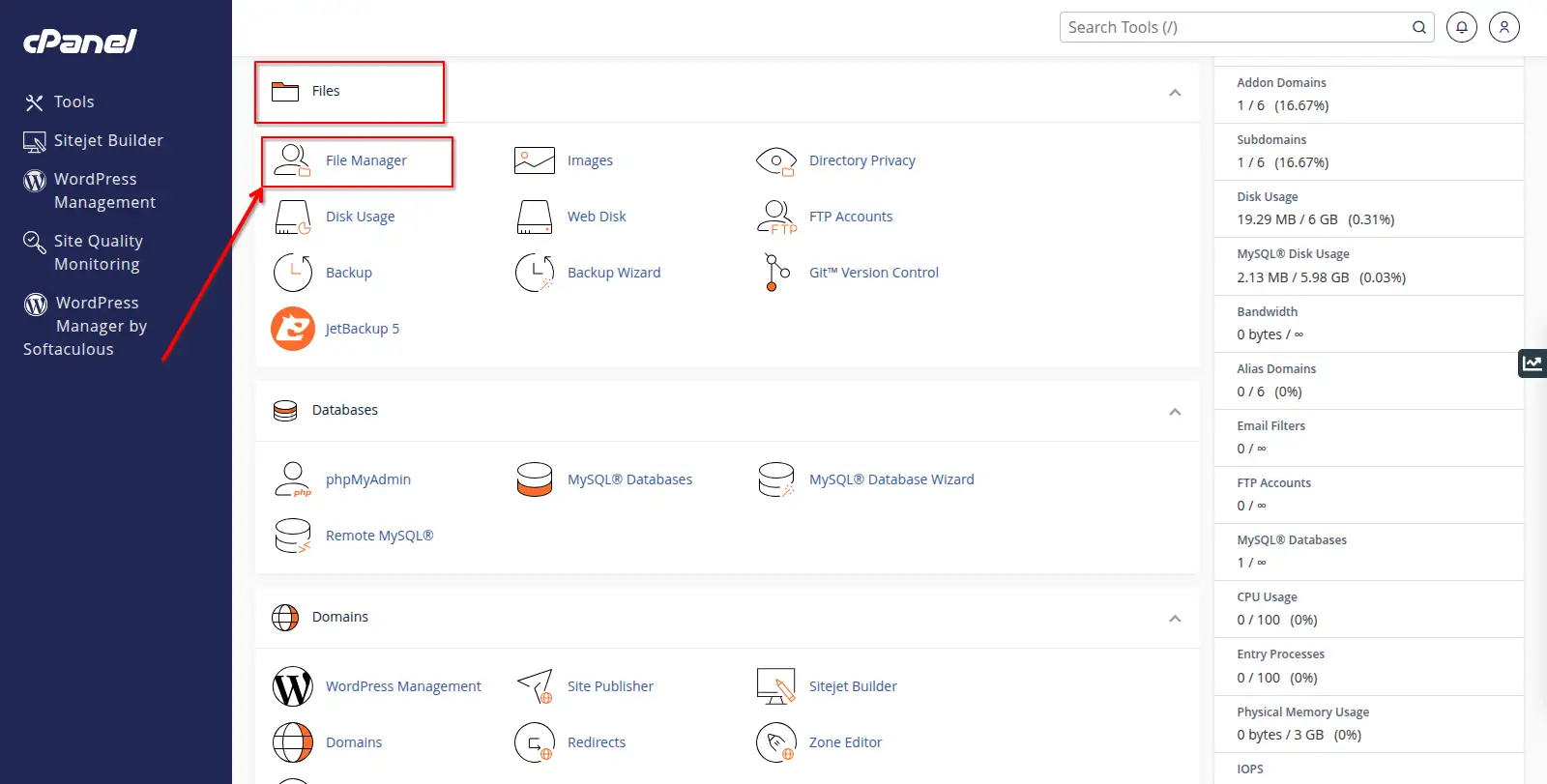

Bước 2: Tạo file robots.txt.

- Truy cập Files > File Manager.

- Truy cập vào thư mục gốc của website và thêm file

robots.txt.- Nhấn vào nút + File.

- Nhập tên file là:

robots.txt. - Cuối cùng nhấn Create New File để tạo file.

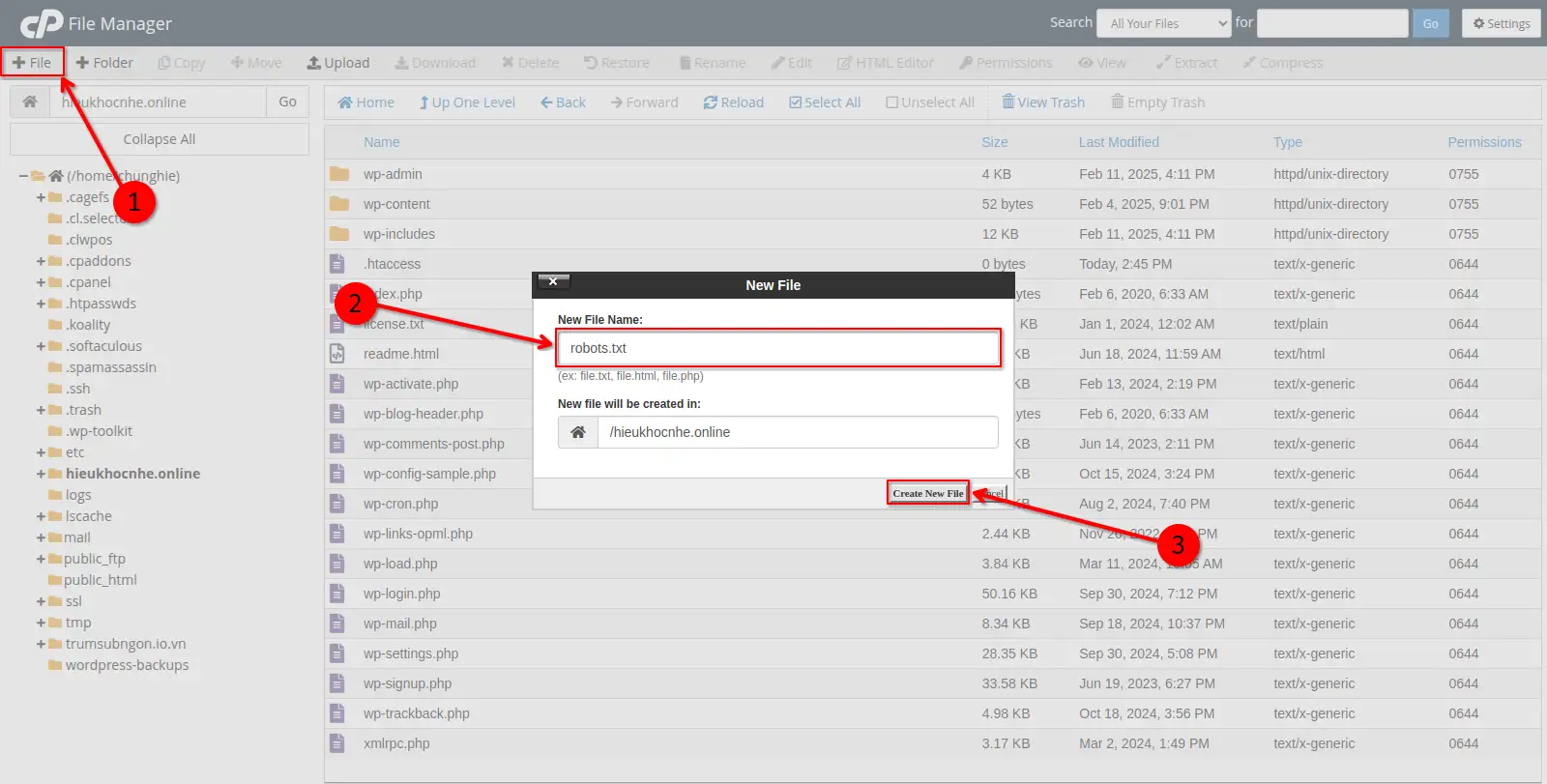

- Sau đó, bạn hãy nhấn chuột phải vào file

robots.txtvà nhấn Edit.

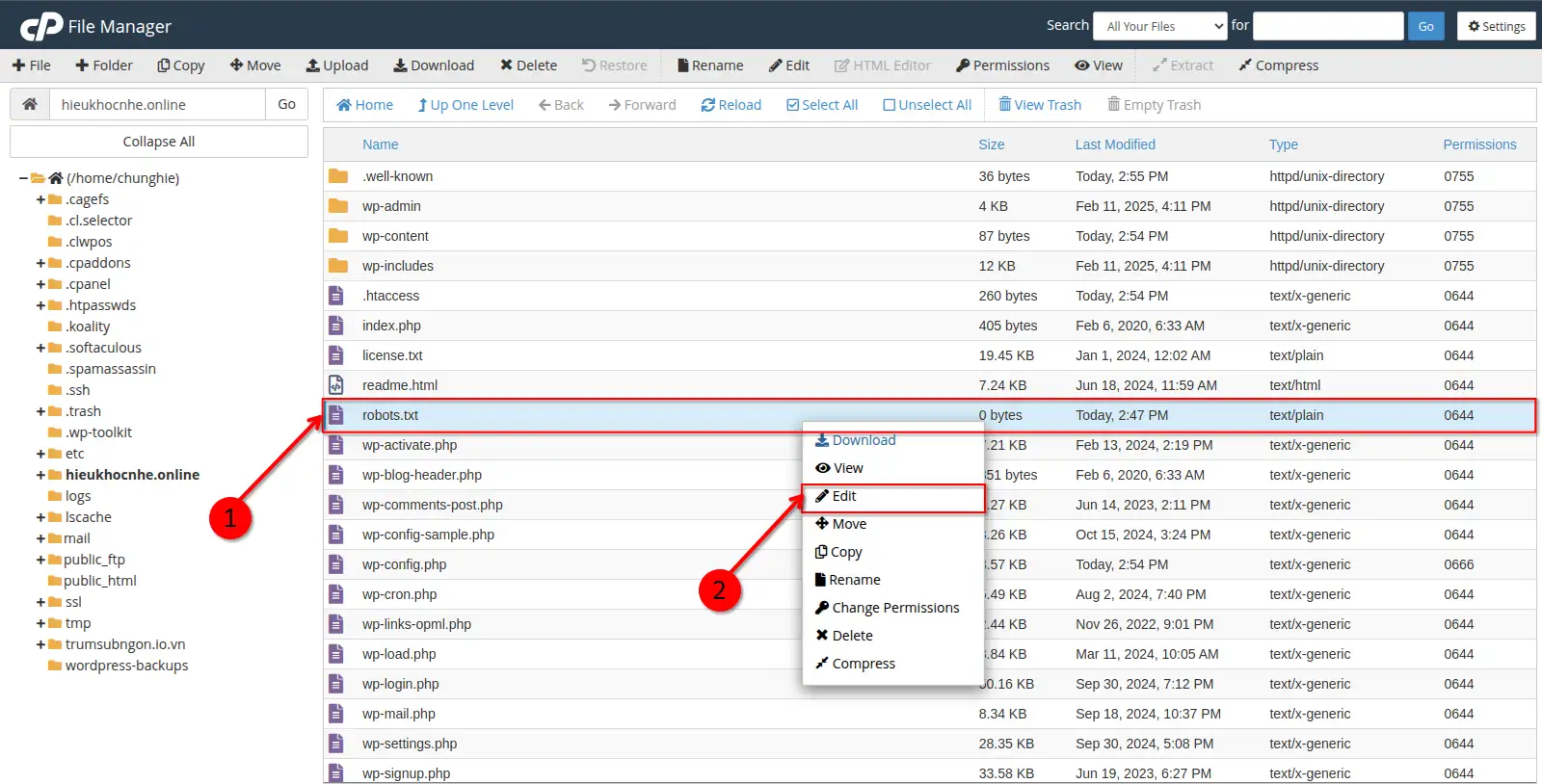

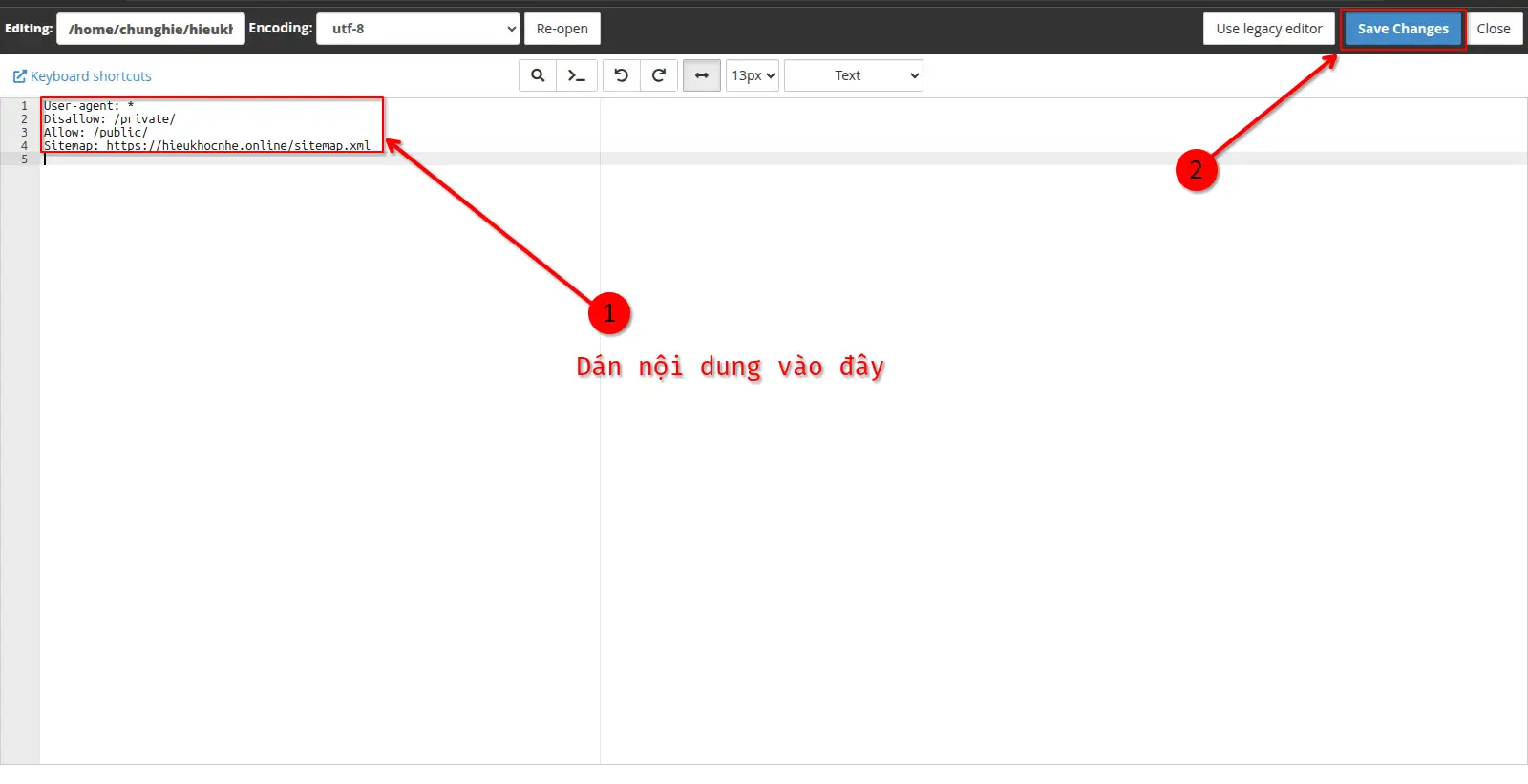

- Tiếp đến hãy dán đoạn mã sau vào file

robots.txt, nhấn Save Changes để lưu thay đổi. - Lưu ý: bạn cần phải thay

example.comthành tên miền của bạn.

User-agent: * Disallow: /private/ Allow: /public/ Sitemap: https://example.com/sitemap.xml

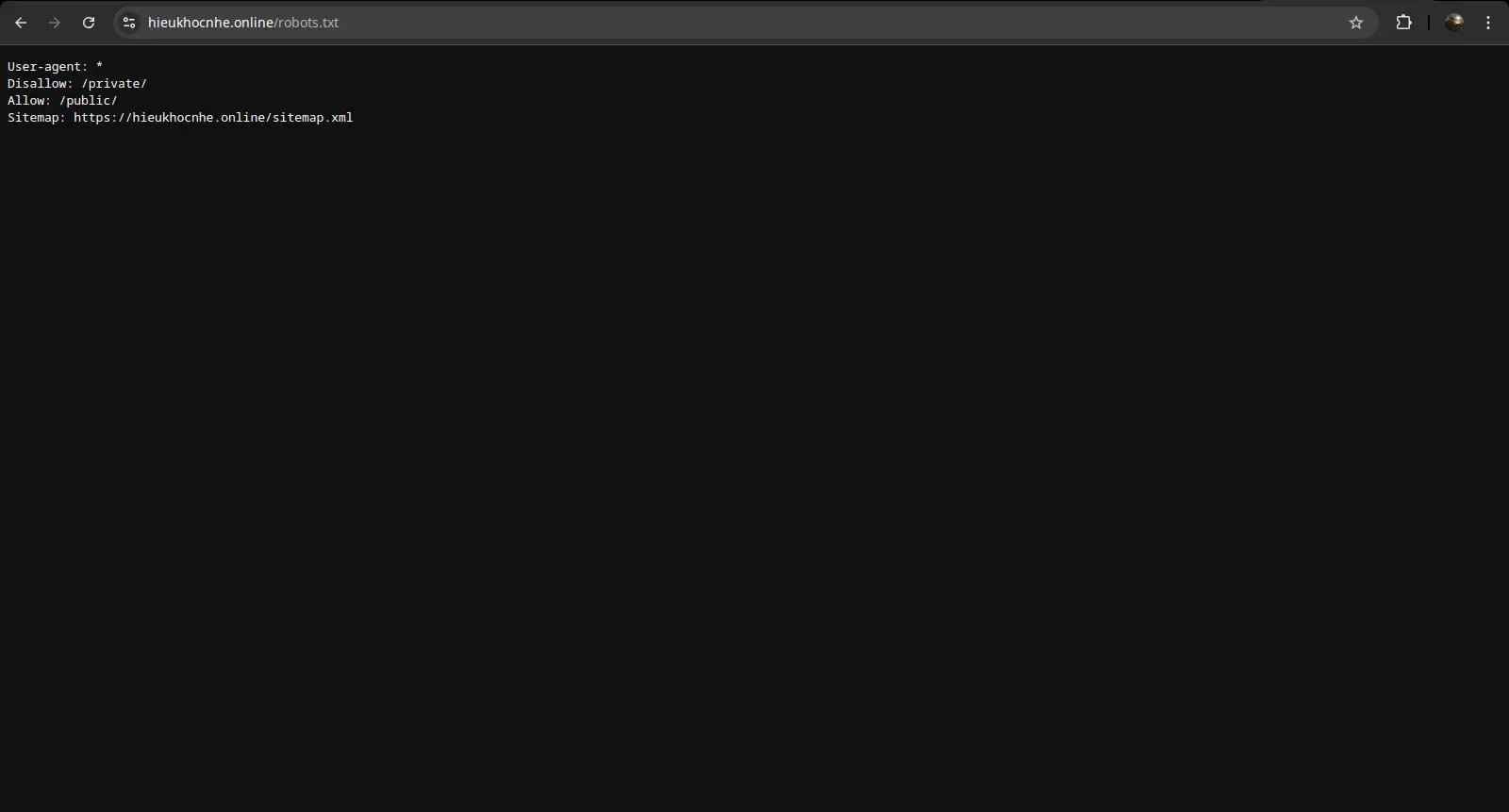

Bước 3: Kiểm tra file robots.txt.

Bạn có thể kiểm tra bằng cách truy cập:

https://yourdomain.com/robots.txt

Hoặc bạn có thể sử dụng công cụ Google Search Console > Robots.txt Tester để kiểm tra.

Lưu ý quan trọng

- Đừng vô tình chặn tất cả bot bằng dòng

Disallow: /,trừ khi bạn muốn ẩn toàn bộ website. - Luôn kiểm tra file

robots.txtcó hoạt động đúng không bằng công cụ kiểm tra của Google. - Đừng dựa vào file

robots.txtđể bảo mật dữ liệu nhạy cảm, vì nó chỉ hướng dẫn bot mà không ngăn chặn truy cập trực tiếp.

Kết luận

Sau khi tạo và chỉnh sửa file robots.txt, bạn đã có thể kiểm soát cách các công cụ tìm kiếm thu thập dữ liệu trên website của mình. Việc thiết lập đúng giúp bảo vệ các trang quan trọng, tối ưu tốc độ thu thập dữ liệu và cải thiện thứ hạng SEO. Chúc các bạn thành công.